Vectorization

Layer가 몇개이든 동일한 방식으로 처리하면 된다.

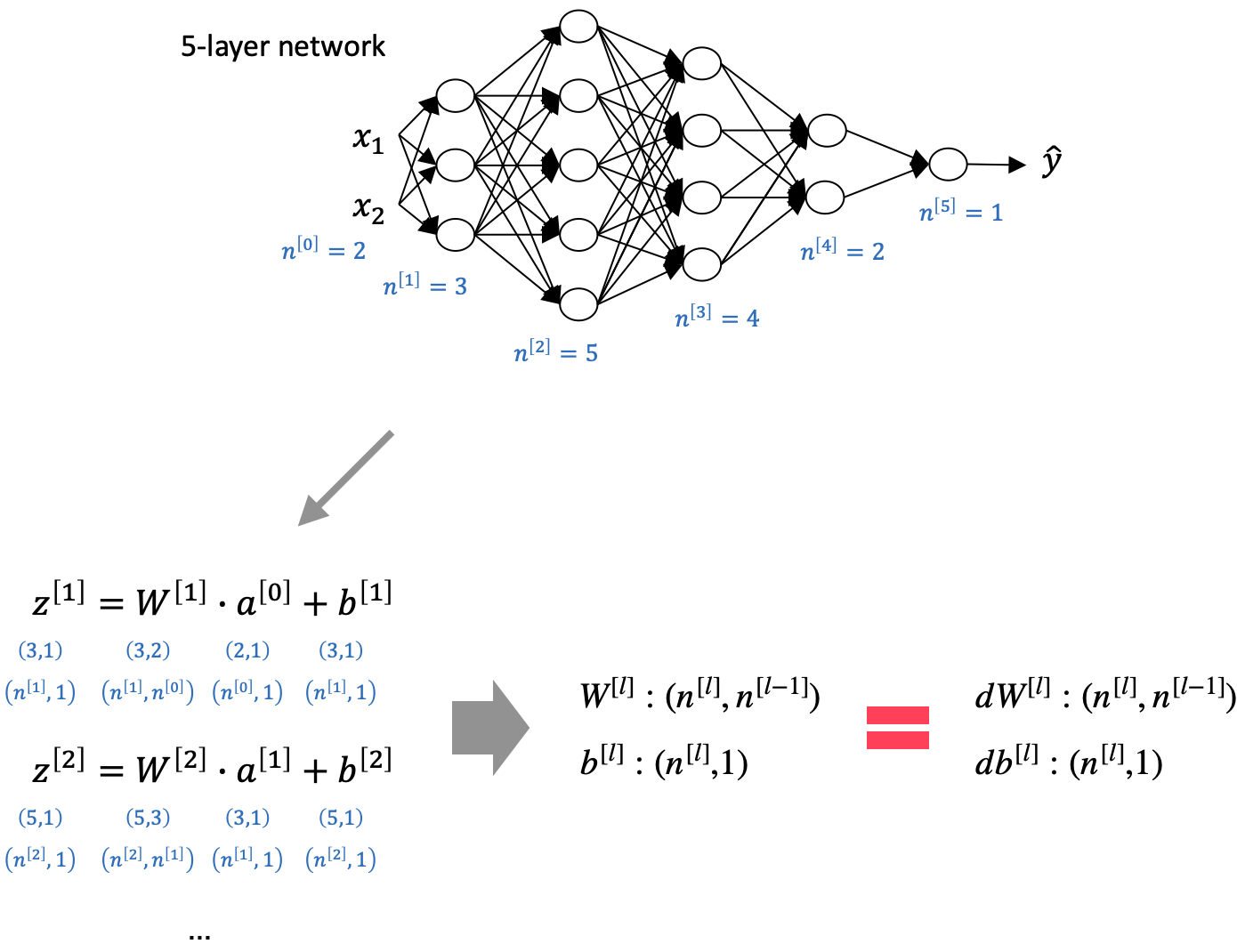

아래와 같이 각 layer의 값들을 하나의 matrix로 표현하여 vectorization을 할 수 있다.

Vectorization을 지원하는 메소드/함수를 사용하면 연산 속도가 월등히 빨라질 수 있다.

Shape

Vectorization을 했을 때 forward propagation에서의 matrix shape은 backward propagation의 matirx shape과 동일하다.

- $W^{[l]}$, $dW^{[l]}$ : $(n^{[l]}, n^{[l-1]})$

- $b^{[l]}$, $b^{[l]}$ : $(n^{[l]}, 1)$

- $Z^{[l]}$, $dZ^{[l]}$ : $(n^{[l]}, 1)$

- $A^{[l]}$, $dA^{[l]}$ : $(n^{[l]}, 1)$

'Computer Science > AL, ML' 카테고리의 다른 글

| Deep Neural Network의 Propagation (0) | 2022.04.20 |

|---|---|

| Neural Network에서 Layer 수 vs. Unit 수 (0) | 2022.04.20 |

| Deep Neural Network (DNN) (0) | 2022.04.20 |

| XOR with Neural Network (0) | 2022.04.20 |

| Activation Function (0) | 2022.04.10 |

댓글