Regularization

Regularization은 overfitting을 막고 variance를 낮춘다.

원리

큰 네트워크로 풀려다가 overfitting이 됬으므로 이 네트워크를 작게 만들어준다.

Regularization은 w를 0에 가깝도록 만들어서 일부 unit을 제거되게(되는 것처럼)하여 네트워크를 축소시킨다.

어떤 unit을 제거하고 어떤 unit을 남길지는 네트워크가 알아서 결정한다.

상세 원리

방법

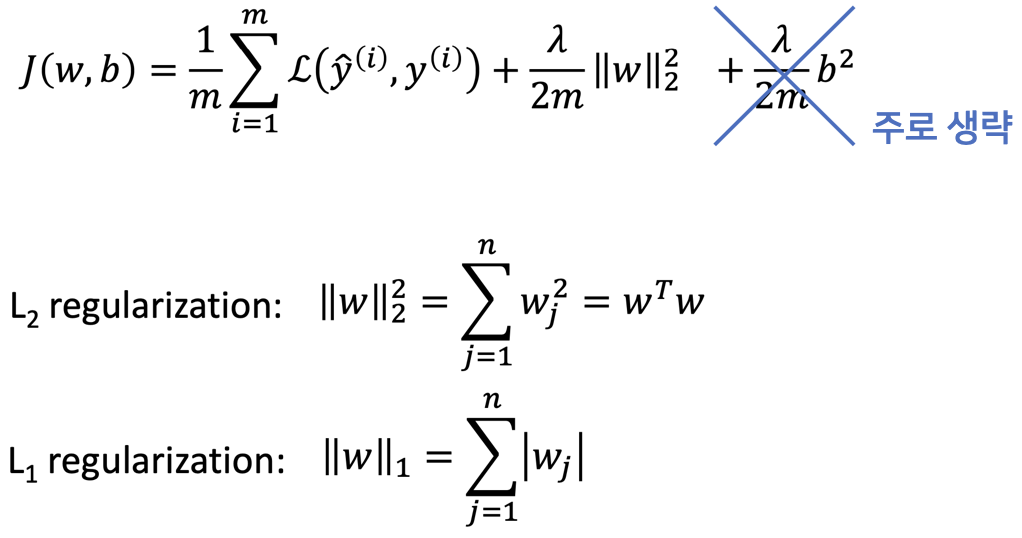

Loss function에 추가적인 항(regularization term)을 둔다.

이를 통해 원래 문제를 잘 풀면서 웬만하면 w가 0에 가까워지도록 한다.

우리가 가지는 b의 개수가 w의 개수보다 작기 때문에 마지막 항의 영향이 미미해져서 주로 마지막 항은 생략한다.

Regularization Parameter

$\lambda$는 regularization parameter로, hyperparameter이다.

적당한 $\lambda$를 구하는 것이 중요하다.

- $\lambda$가 0에 가까워질수록 regularization을 하지 않는 것을 의미한다. (overfitting 발생)

- $\lambda$가 커질 수록 regularization을 심하게 하는 것을 의미한다. (high bias 문제 발생)

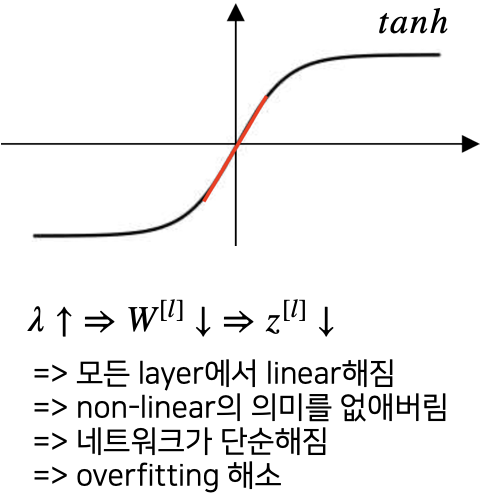

수학적인 증명

Weight decay로 인해 w의 값이 작아진다.

'Computer Science > AL, ML' 카테고리의 다른 글

| Early Stopping - Overfitting 방지 (0) | 2022.04.20 |

|---|---|

| [Regularization] Dropout (0) | 2022.04.20 |

| [네트워크 성능] HyperParameter (0) | 2022.04.20 |

| [네트워크 성능] Bias, Variance (0) | 2022.04.20 |

| [네트워크 성능] Dataset (0) | 2022.04.20 |

댓글