Adam

현재 가장 널리 사용되는 optimization 기법이다.

특징

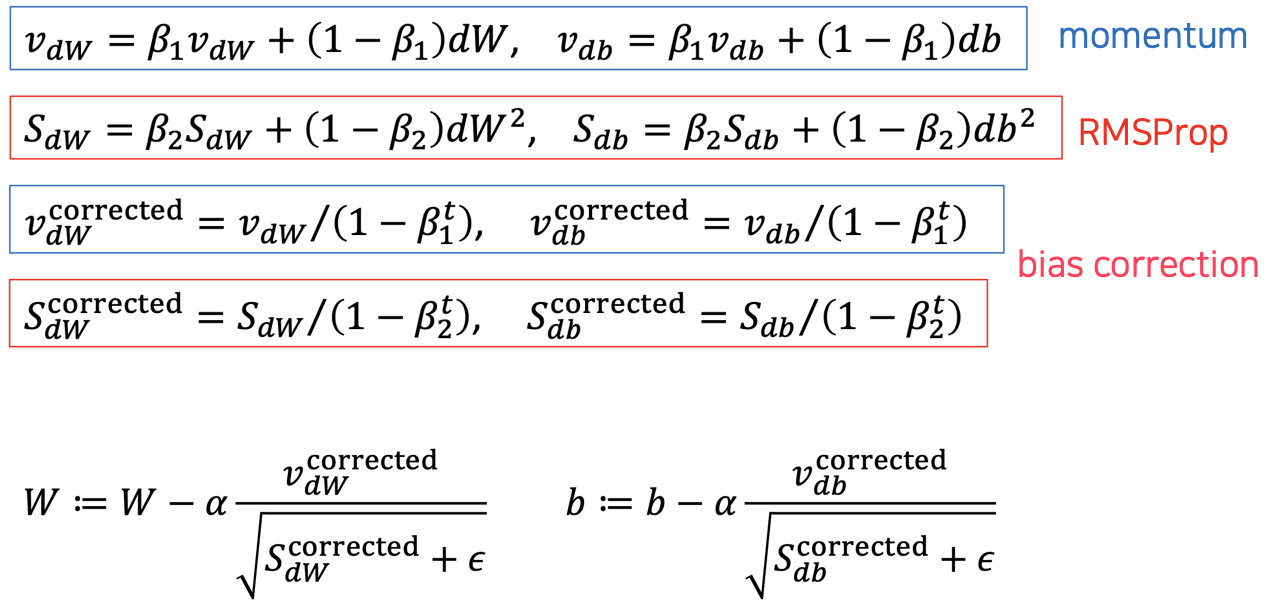

- Gradient descent with momentum과 RMSProp이 결합된 형태이다.

- gradient descent with momentum

- gradient 자체에 smoothing을 걸어줌(exponentially weighted average)

- RMSProp

- gradient에 smoothing을 걸고 그것으로 gradient를 나눠줌

- gradient가 커지지 않도록 함

- gradient descent with momentum

- 어떤 상황에서도 gradient가 커지지 않도록 해서 전반적으로 유사한 gradient를 가지게 한다.

방법

- $\beta_1$ : momentum에 대한 것

- $\beta_2$ : RMSProp에 대한 것

(momentum + RMSProp) → bias correction → update

Hyperparameter

- $\alpha$

- learning rate

- adam에서는 $\alpha$에 대한 영향이 적음

- $\beta_1$

- $dW$에 대한 weighted average

- 주로 0.9 사용

- $\beta_2$

- $dW^2$에 대한 weighted average

- 주로 0.999 사용

- $\epsilon$

- 주로 $10^{-8}$ 사용

'Computer Science > AL, ML' 카테고리의 다른 글

| [Optimization] Local Optima in Neural Network (0) | 2022.04.21 |

|---|---|

| [Optimization] Learning Rate Decay (0) | 2022.04.21 |

| [Optimization] RMSProp (0) | 2022.04.21 |

| [Optimization] Gradient Descent with Momentum (0) | 2022.04.21 |

| [Optimization] Exponentially Weighted Average (0) | 2022.04.21 |

댓글